Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- consultant

- 전략프로젝트

- 컨설팅강의

- Russia

- consulting

- 컨설턴트

- 전략컨설턴트

- 전략강의

- ey

- 경영컨설팅

- 케이스 인터뷰

- 전략펌

- 컨설팅펌

- caseinterview

- 케이스 스터디

- 전략 컨설팅

- 빅4

- 러시아

- 커리어

- case interview

- 게스티메이션

- 케이스인터뷰

- 인공지능

- Strategy

- 컨설턴트교육

- 컨설팅 인터뷰

- 전략컨설팅

- 컨설팅

- 리더십

- strategy consulting

Archives

- Today

- Total

Consultants Blogger

생성형 AI 개념의 이해 본문

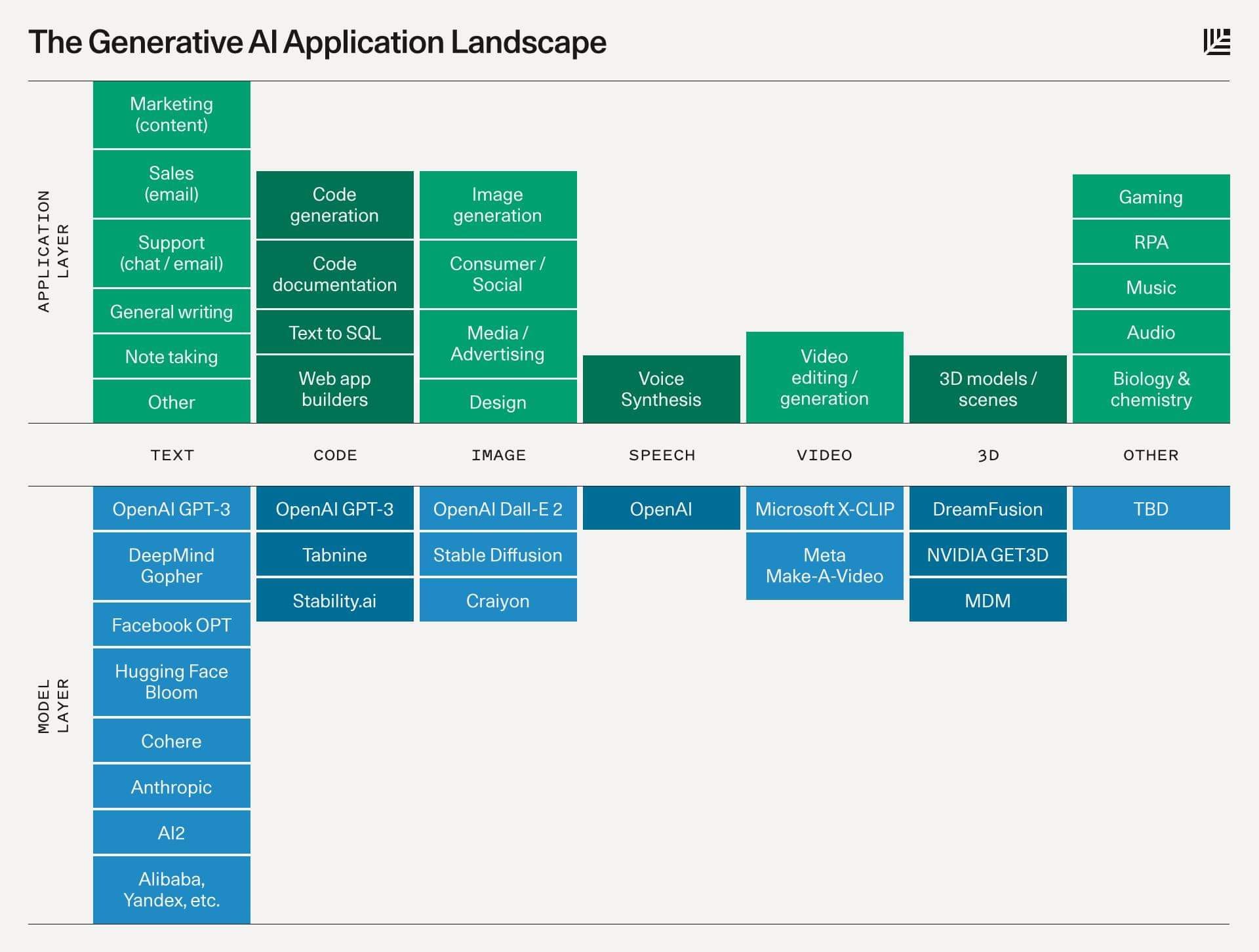

요즘 계속해서 생성형 AI 라는 용어가 화두인데, 정확한 정의에 대해서는 사람들 모두 조금씩 그 범주가 상이한 것 같다.

예전에 내가 몸담았던 곳에서 추진했던 것들 중 GAN이나 Diffusion, VITS 같은 생성 모델을 활용해서 결과물을 만들어 내는 것이 생성형AI라고 생각했었는데, 정확히는 이게 생성 모델이라고 확인했다.

생성모델은 말 그대로 Text, audio, image 를 생성할 수 있는 알고리즘과 모델 프레임워크, 아키텍처의 집합체라고 하는데, 흔히 회자되는 생성형 AI는 여기에 한 가지 개념이 더 추가되게 된다. 바로 ChatGPT, 즉 LLM 으로 대표되는 '초거대 AI'라는 컨셉이다. 이게 왜 꼭 필요한지는 모르겠으나, 일종의 마케팅 목적이 아닐까 싶다.

실제로 하나의 모델이 특정 목적을 위해 적은 양의 데이터로 학습을 시켜 놓은 것은 Specific 모델이라고 했는데, 그것들이 누적되어 적은 학습 데이터로도 아웃풋을 만들어 낼 수 있을 정도로 많이 학습 시켜 놓은 것은 general/generic 모델이라고 했었다. 즉, Encoder 후 Latent space (Vector)에 아주 많은 데이터로 points를 찍어 놓아 지형도가 섬세하게 그려져 있다면, 다음 output을 창출해 낼 때 더 적은 데이터로 만들 수 있고, input과 output type 이 같으면 (예. text to text, image to image) 스스로 학습할 수 있는 data 를 만들어 낼 수도 있다는 개념, 이걸 auto-encoder라고 한단다. 그리고 여기에 확률적 개념이 들어가면 VAE (Variational Auto-Encoder)라고.

이 개념이 이제 여기 저기서 너도 나도 하겠다는 것이라는 느낌이 강하게 들었다.

그 정도 데이터로 generic 모델을 만들려면(물론, 그 용도와 범주에 따라 상이할 수는 있을 것인데), 일개 회사가 과연 할 수 있을까도 궁금하고, 사실 파다보면 이미 만들어져 있는 초거대 AI 모델에 플러그 인 하거나 Specific domain knowledge를 학습(fine-tuning)하여 쓰고 있는 경우가 많은 것으로 보인다. (plug-in이나 Cohere 등)

개념적 정의의 실체야 지속해서 스터디해 나가며 파 보겠지만, Use Case 관점에서 함께 이야기를 나눌 수 있는 분이 계시면 티 타임이라고 한번 간청 드리고 싶다.

'Generative AI (생성 AI) 란? - 개념, fine tuning, 활용'

Generative AI (생성 AI) 란? - 개념, fine tuning, 활용

Generative AI는 비정형 딥 러닝 모델을 사용하여 사용자 입력을 기반으로 콘텐츠를 생성하는 인공지능의 일종입니다. 이용자의 특정 요구에 따라, 결과를 능동적으로 생성하는 인공지능 기술을 통

www.thedatahunt.com

'AI 이해에 필요한 개념 7가지 - 신경망, LLM, GAN, 컴퓨팅, 블랙박스, 미세조정, 정렬'

AI 이해에 필요한 개념 7가지 - AI타임스

최근 인공지능(AI) 기술이 빠르게 발전하면서 과거에는 볼 수 없었던 성과들이 쏟아지고 있다. 특히 글이나 이미지, 동영상 그리고 프로그래밍 코드까지 만들어내는 생성 AI는 많은 분야에서 혁

www.aitimes.com

'Useful Knowledge for Life' 카테고리의 다른 글

| 인도 출장 (2) | 2023.09.24 |

|---|---|

| 생성형 AI 개념 정리 2 (0) | 2023.09.07 |

| 실패와 나의 현황을 잘 파악하는 것의 중요성 (0) | 2023.08.09 |

| 베트남 나트랑 여행 꿀팁 (0) | 2023.08.05 |

| 생성형 AI 도입과 활용에 대한 소고 (0) | 2023.08.03 |